Heute dreht sich alles um die robots.txt. Ich zeige Dir, wie Du die robots.txt schnell und einfach in nur einer Minute erstellst, sodass Deine Webseite die Crawler von Google und Co. und somit auch für die Suchmaschinenoptimierung (SEO) bereit ist!

Inhaltsverzeichnis:

Was ist eine robots.txt?

Die robots.txt ist eine Textdatei, welche im Backend angelegt wird und den Crawlern der Suchmaschinen eine Laufkarte an die Hand gibt, mit der die Webseite absucht ohne sich zu verlaufen.

Warum braucht man eine robots.txt?

Die robots.txt ist die erste Datei, welche aufgerufen wird, wenn ein Bot/ Crawler sich die Webseite ansieht, sie sagt dem Crawler, wo er die Webseite absuchen darf und welche Bereiche er nicht „crawlen“ soll.

Was ist in einer robots.txt?

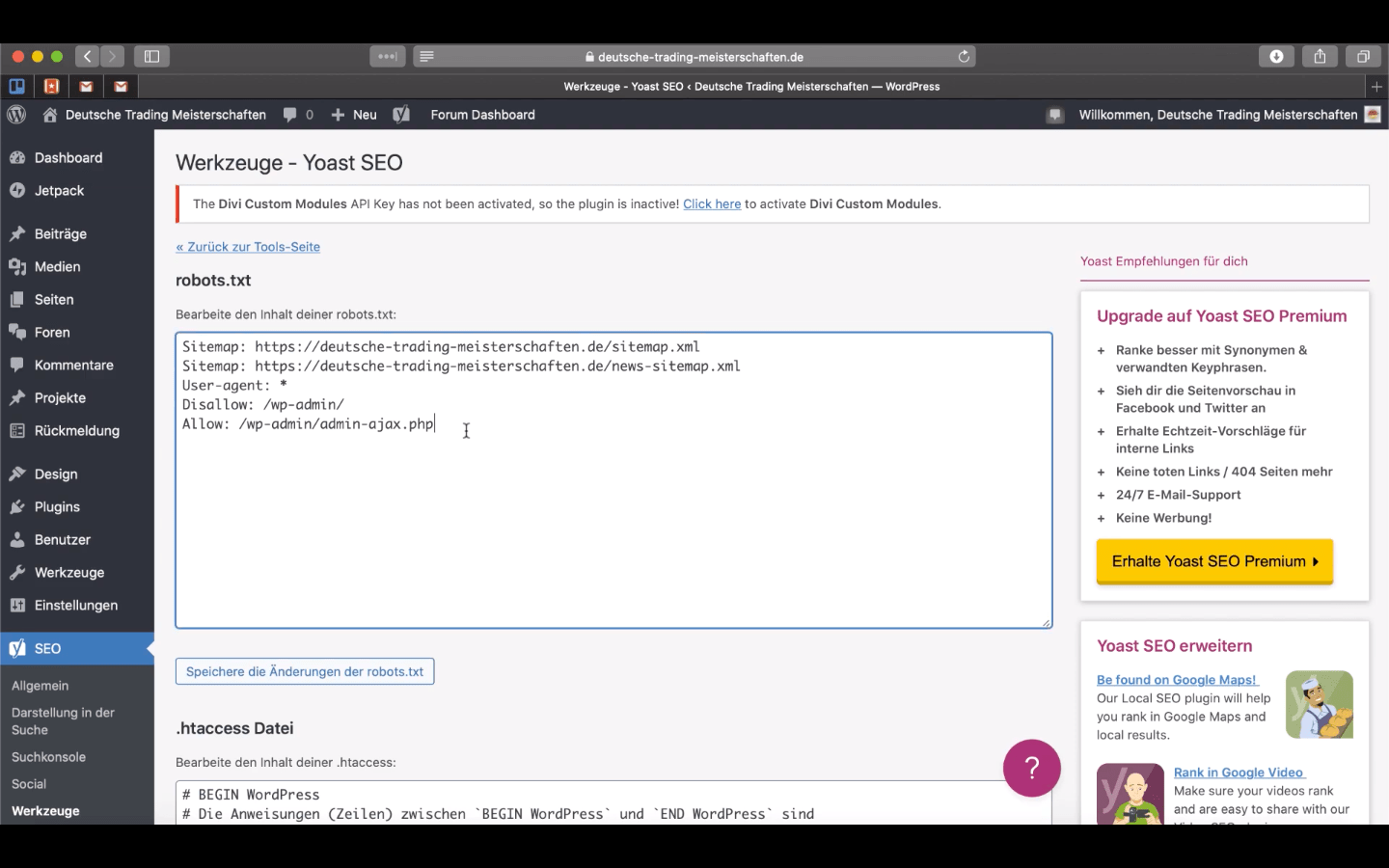

Innerhalb der robots.txt wird die XML-Sitemap angegeben, um den Crawlern die Linkstruktur zu erklären und die Whitelist und Blacklist der Seiten und Subdomains aufgeführt, um sie nicht zu indexieren und aus der Wertung der Suchmaschine auszuschließen. Die robots.txt ist nämlich besonders für das Ranking in den Suchmaschinen ausschlaggebend und Bedarf einem ausgeklügeltem Konzept. Seiten wie z.B. ein Login oder solche mit doppeltem Inhalt können einen bei der Bewertung schnell auf die Füße fallen, aber sperrt man die Bots aus zu vielen Seiten aus kann sich das auch negativ auf das Ranking und die Platzierung auswirken. Somit ist es wichtig, die Crawler nicht zu sehr einzuschränken.

Robots.txt erstellen | Schritt für Schritt Anleitung

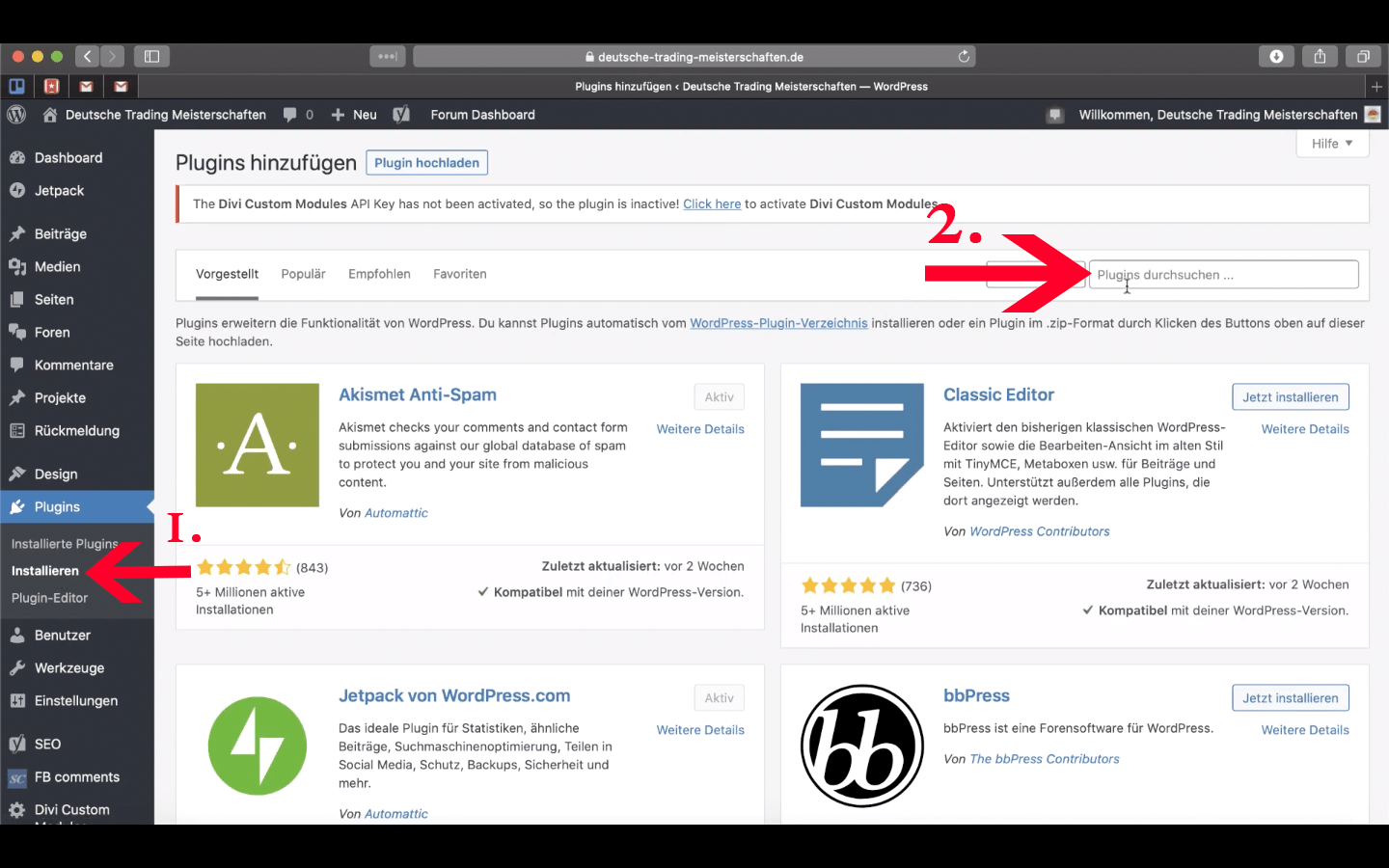

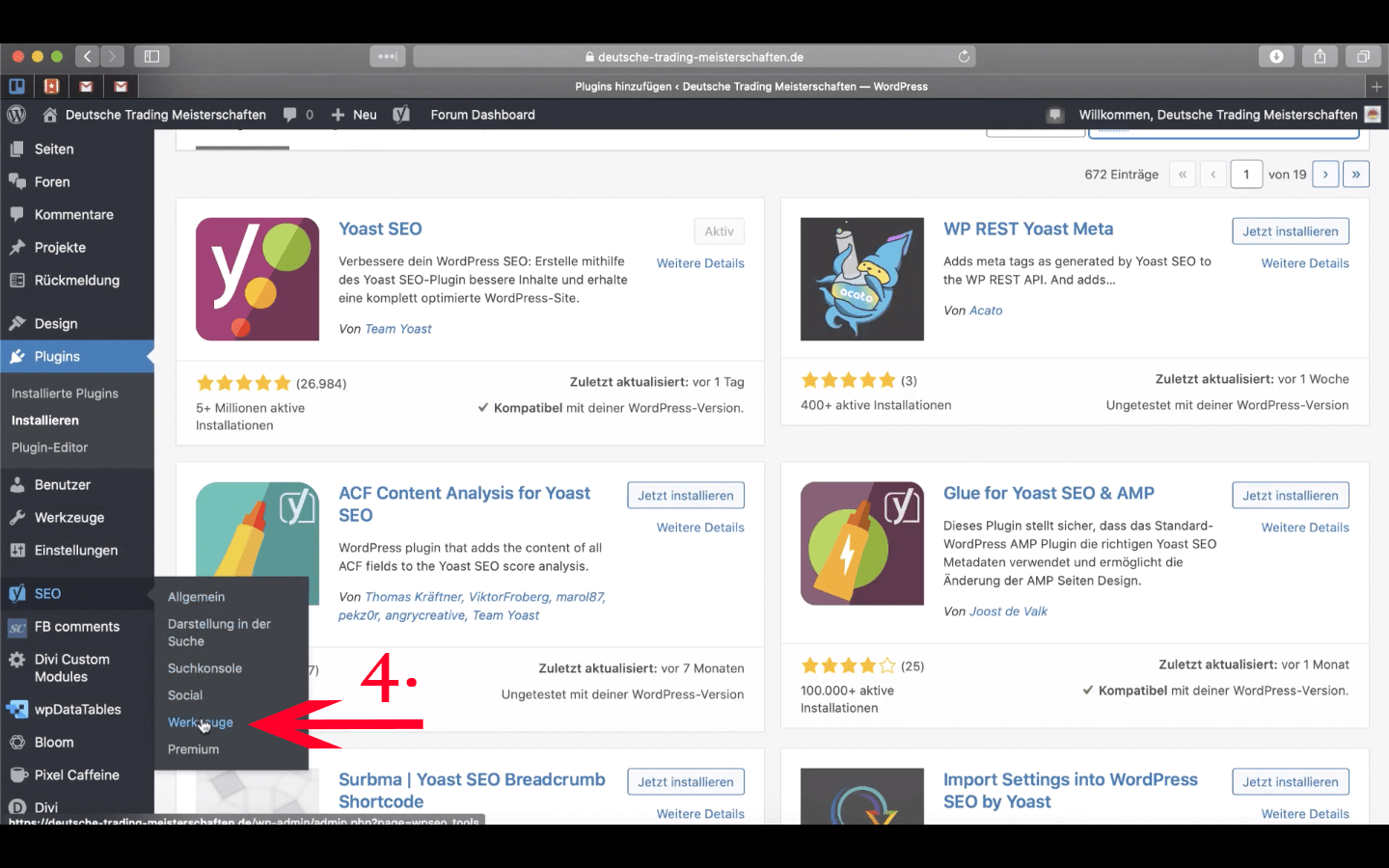

Unter „Plugins“ auf „Installieren“ klicken

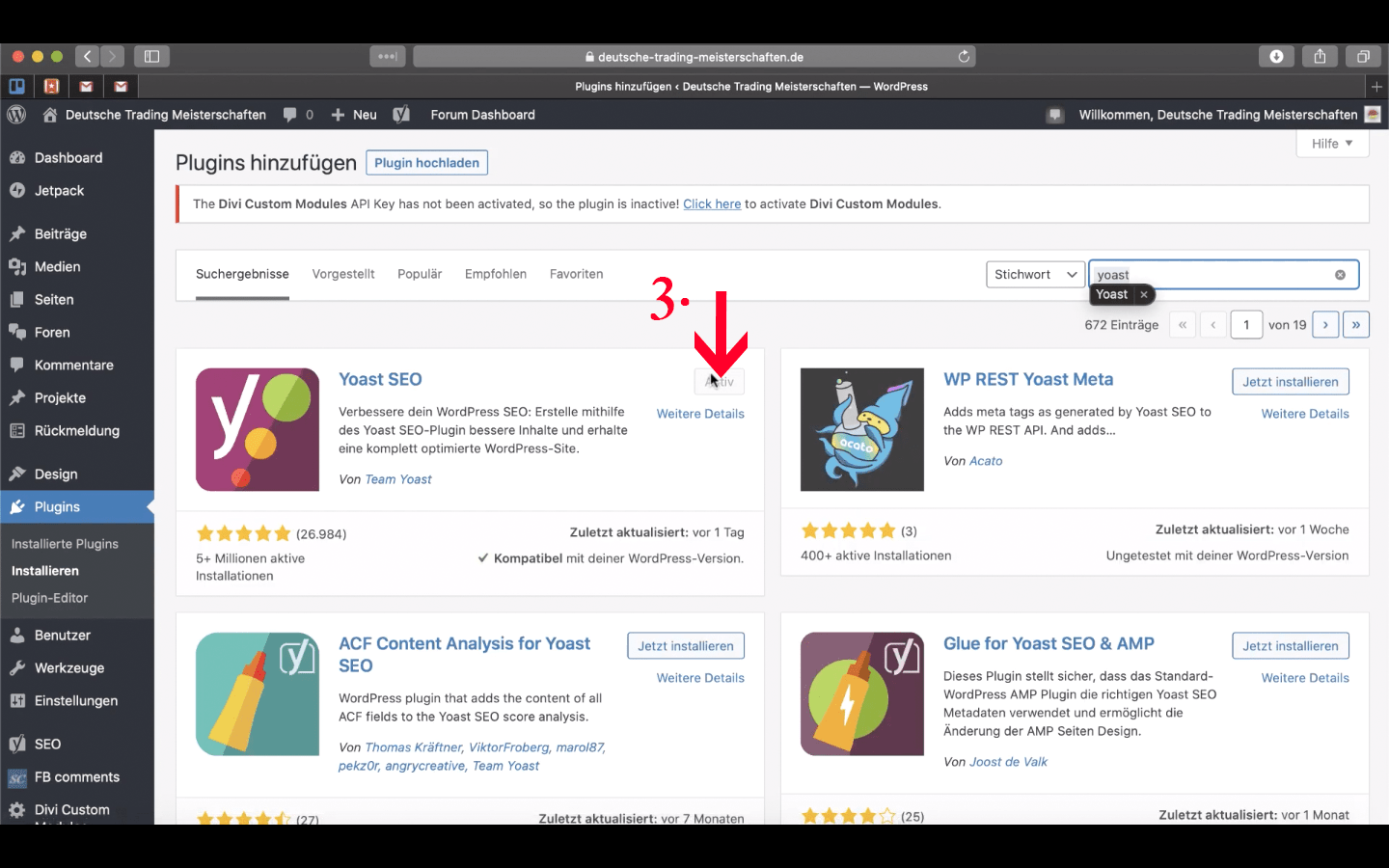

In „Plugins durchsuchen“ nach „Yoast“ suchen

Plugin installieren und aktivieren

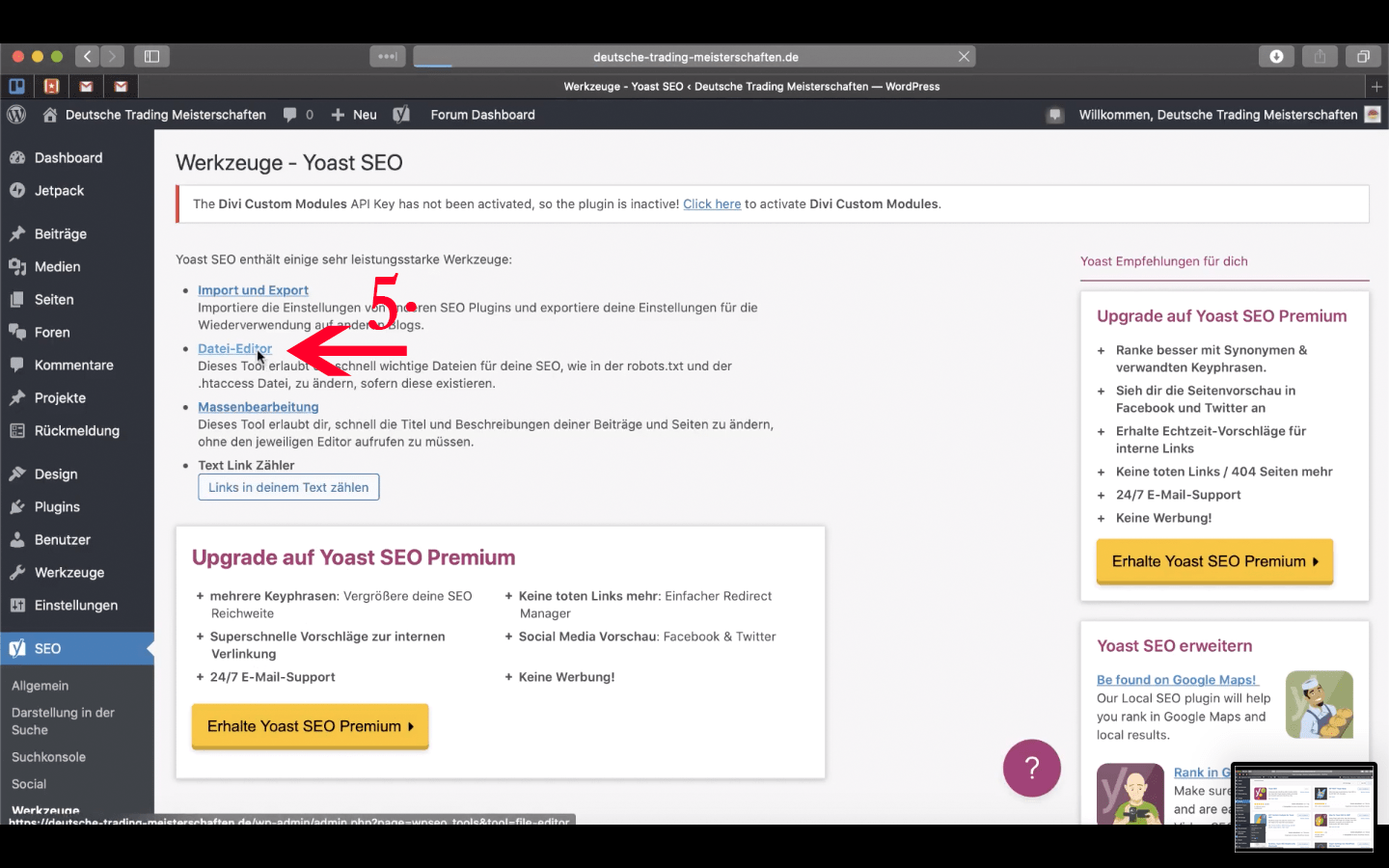

Unter „SEO“ auf „Werkzeuge“ gehen

Auf „Datei-Editor“ klicken

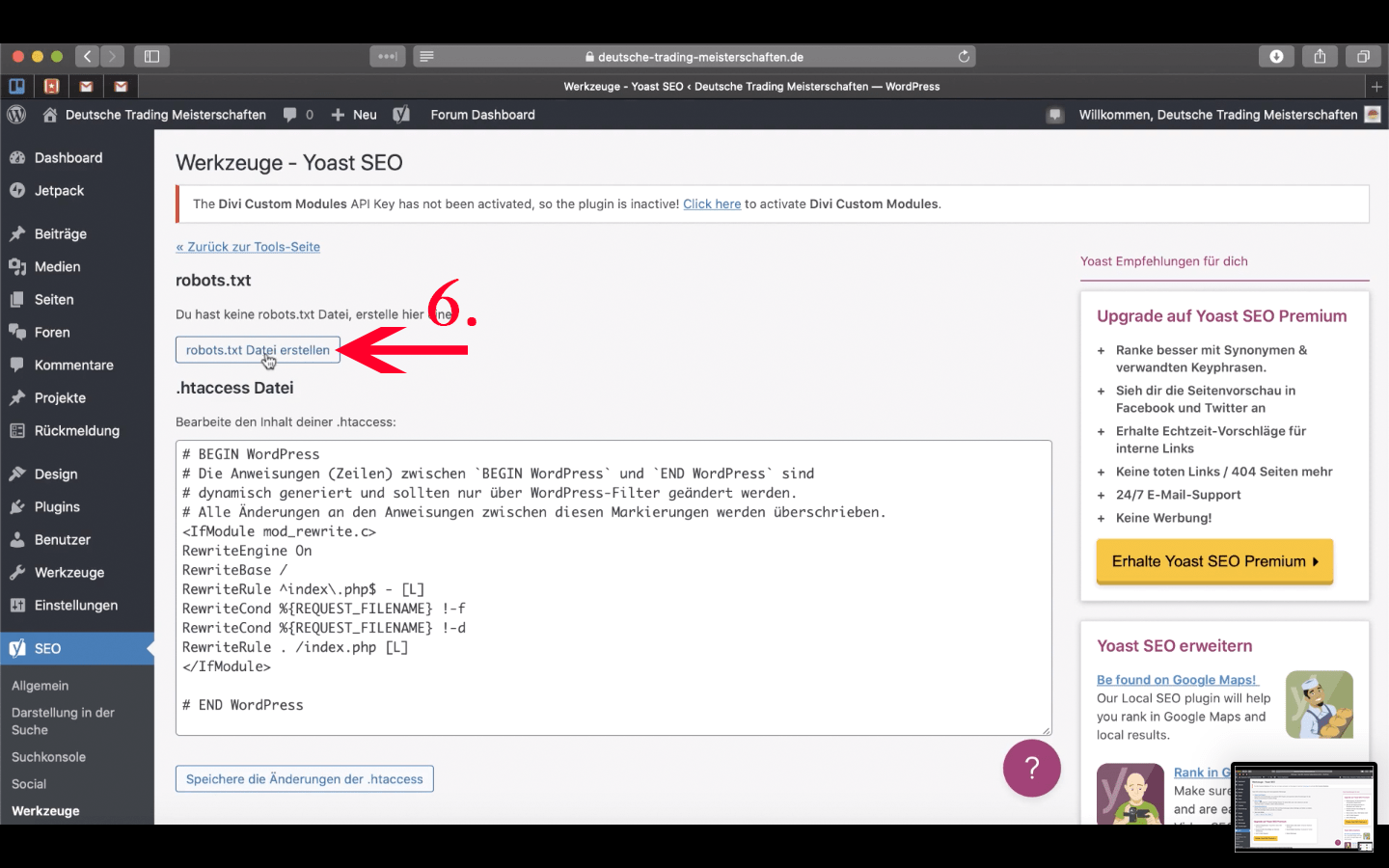

„robots.txt Datei erstellen“ anklicken

Ich hoffe, dass ich Dir mit diesem Artikel helfen konnte und wünsche Dir auch weiterhin viel Spaß beim Optimieren Deiner Webseite.

Möchtest Du auch weiterhin in der Welt von SEO, SEA und den Suchmaschinenrankings auf dem laufenden bleiben, dann empfehle ich Dir meinen Artikel: Die 11 besten deutschsprachigen SEO-Webseiten und SEO-Blogs.

Liebe Grüße aus Berlin,

Erik